Kiến trúc của DataRobot "Cấp Độ Cao"

BigQuery Data Engineering Agents ra mắt nhằm hỗ trợ các nhà phân tích và kỹ sư dữ liệu làm việc nhanh

Search

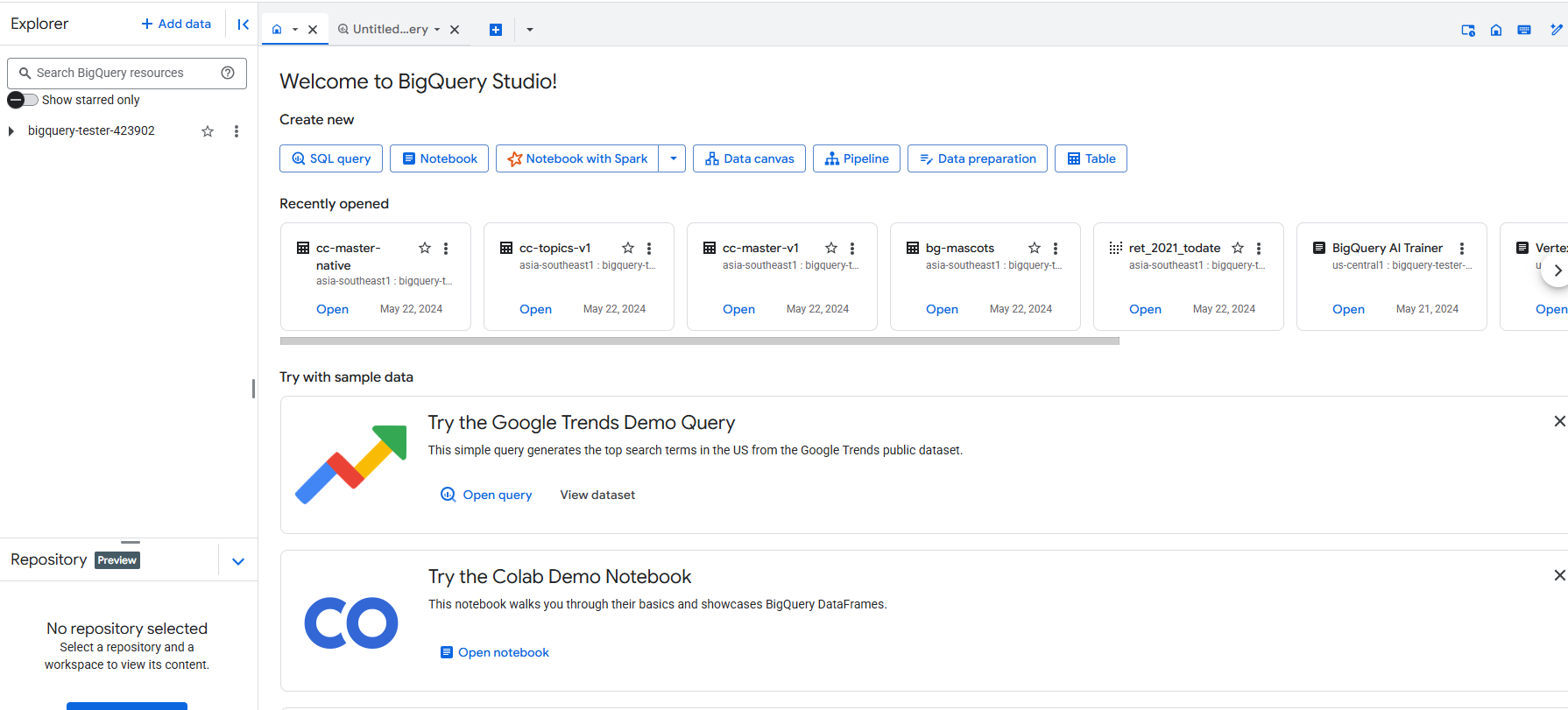

Ê mấy bạn SumoTechers ơi! Hôm nay tụi mình sẽ cùng nhau khám phá một "chiêu" mới siêu hay ho để tận dụng BigQuery, giúp dân Data Analyst và Data Engineer tụi mình làm việc nhanh hơn, hiệu quả hơn. Đó chính là sử dụng AI Agent trong BigQuery để tạo pipeline dữ liệu chỉ với vài câu lệnh đơn giản. Nghe hấp dẫn chưa?

Mình vừa xem được một video demo cực kỳ ấn tượng, và giờ mình muốn chia sẻ lại với các bạn cách để "hô biến" BigQuery thành siêu năng lực, tiết kiệm thời gian mà lại còn "xịn xò" nữa. Sẵn sàng chưa nào? Let's go!

Mình sẽ chia nhỏ quy trình ra thành các bước nhỏ, dễ thực hiện, kèm theo những mẹo nhỏ để bạn không bị "tẩu hỏa nhập ma" nha!

Đầu tiên, mình cần tạo một dataset để chứa dữ liệu của mình. Trong ví dụ này, mình sẽ tạo dataset "SFDC_dataset" ở khu vực "US".

Prompt: Create a dataset called SFDC_dataset in location US

AI Agent sẽ tự động tạo code SQL để tạo dataset. Bạn chỉ cần xem lại code, đảm bảo mọi thứ ổn, rồi chấp nhận thay đổi và chạy pipeline. Siêu nhanh!

Giả sử bạn đã có dữ liệu trong một bucket trên GCS. Bây giờ mình sẽ yêu cầu AI Agent load dữ liệu từ bucket này vào BigQuery.

Prompt: Load all of my files from the GCS bucket. Create physical tables based on the schemas in the parquet files. Use the same names in the files for the tables. [Listing specific files here]

Mẹo SumoTech: Thay vì chỉ nói "load all files", hãy liệt kê cụ thể các file bạn muốn load. Như vậy sẽ giúp AI Agent hiểu rõ hơn yêu cầu của bạn và giảm thiểu sai sót.

AI Agent sẽ quét từng file, tạo schema, và tạo bảng tương ứng trong BigQuery. Sau khi hoàn thành, bạn sẽ thấy một bản tóm tắt về những gì nó đã làm, kèm theo giải thích rõ ràng. Thích ghê!

Giả sử bạn muốn phân tích dữ liệu theo quý. Mình sẽ yêu cầu AI Agent tạo một time dimension để dễ dàng thực hiện việc này.

Prompt: Add a time dimension

AI Agent sẽ tự động tạo một bảng time dimension, bao gồm các thông tin như năm, quý, tháng, ngày,... Bạn có thể xem lại definition trước khi chạy pipeline.

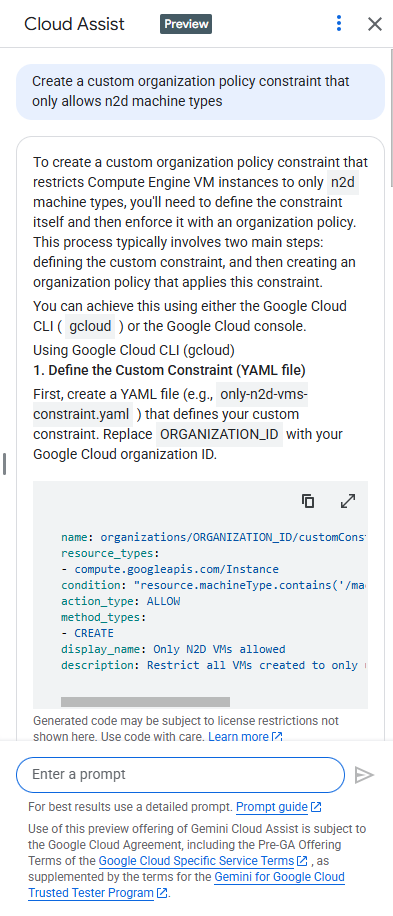

Đây là phần mình thấy "cool" nhất nè! Mình sẽ sử dụng một hàm AI trong BigQuery (kết nối với Vertex AI và mô hình Gemini) để lọc các case hỗ trợ có chứa từ ngữ không phù hợp.

Prompt: Enhance the cases table so that we can easily filter out those cases with profanities.

AI Agent sẽ tạo một cột boolean mới trong bảng "cases" để đánh dấu các case có chứa từ ngữ không phù hợp. Quá tiện lợi!

Lưu ý quan trọng: Để sử dụng tính năng này, bạn cần kết nối BigQuery với Vertex AI và có một mô hình Gemini đang chạy.

Chất lượng dữ liệu luôn là ưu tiên hàng đầu. Mình sẽ nhờ AI Agent kiểm tra chất lượng dữ liệu trong bảng "users".

Prompt: Check data quality for the user table

AI Agent sẽ tự động kiểm tra các lỗi phổ biến, như giá trị null, định dạng email không hợp lệ,... Nếu phát hiện lỗi, nó sẽ tự động sửa hoặc báo cáo cho bạn.

Mẹo SumoTech: AI Agent có thể tự động revert những thay đổi không hợp lệ trong quá trình validation. Quá thông minh phải không nào!

Cuối cùng, mình sẽ yêu cầu AI Agent tạo metadata cho các bảng của mình, để dễ dàng tích hợp với các ứng dụng AI khác.

Prompt: Create metadata for our tables

AI Agent sẽ tạo metadata, bao gồm mô tả về các cột, kiểu dữ liệu, ý nghĩa của các giá trị,... Bạn có thể bổ sung thêm các thông tin chi tiết hơn để metadata trở nên hữu ích hơn.

Lưu ý: Hãy bổ sung thêm thuật ngữ chuyên ngành của bạn và các từ đồng nghĩa để metadata hoàn thiện hơn.

Chỉ với vài dòng prompt đơn giản, mình đã tạo ra một pipeline dữ liệu hoàn chỉnh, bao gồm dataset, bảng dữ liệu, time dimension, chức năng lọc dữ liệu bằng AI, kiểm tra chất lượng dữ liệu, và metadata cho ứng dụng AI. Thật là "vi diệu" phải không nào?

Nếu bạn muốn thử nghiệm tính năng này, hãy tìm link trong phần comment của video gốc. Chúc các bạn thành công và có những trải nghiệm thú vị với AI Agent trong BigQuery!